更新时间:2025-11-04

AICP 2.3.0

1.一体化部署

支持在业务K8S集群的GPU裸金属服务器上创建虚拟机,做到一台GPU裸金属机器跑起AICP平台

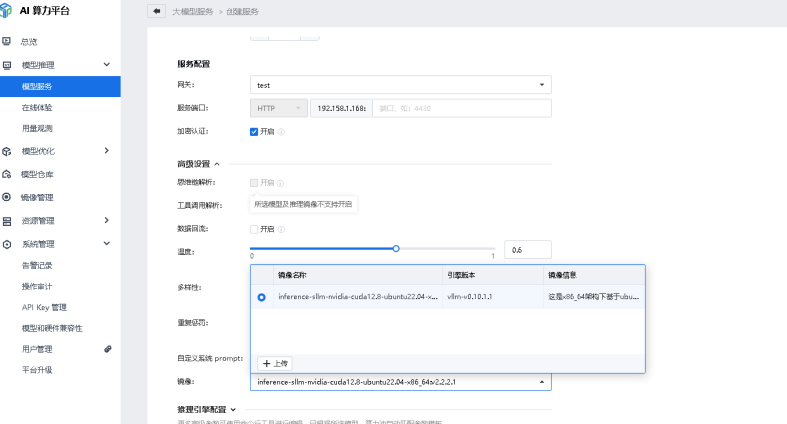

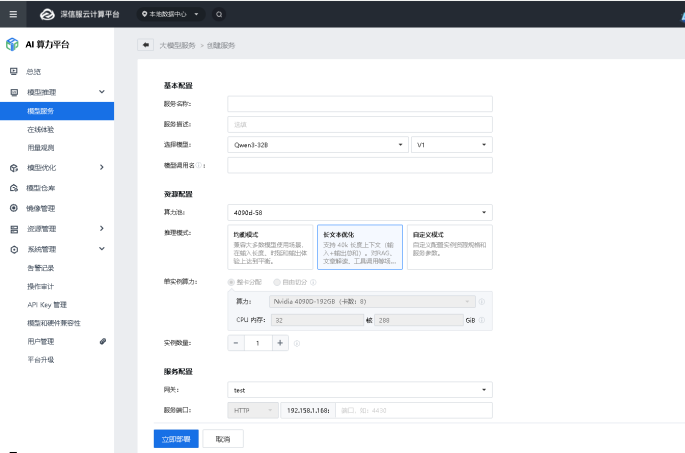

2.支持推理引擎多版本

AICP支持创建模型服务在“自定义模型”场景中,选择推理引擎的版本

3.AICP支持创建模型服务选择不同场景的推理模式

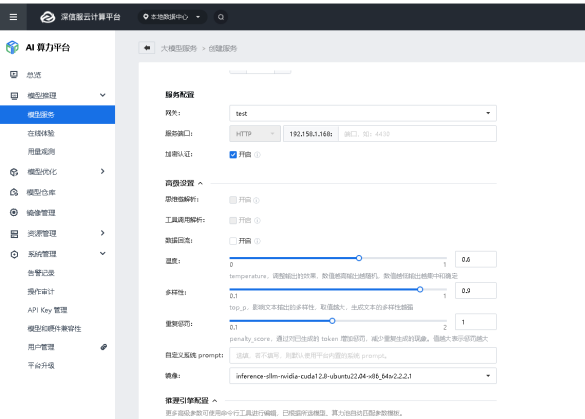

4.部分模型支持思维链&工具调用解析

AICP支持创建模型服务时根据模型的特性选择是否开启思维链解析或者工具调用解析

5.支持模型服务配置多个API Key进行访问

有在模型服务创建时生成的apikey移动至《API Key管理》,并支持同个服务配置多个key

6.API Key 管理

支持模型服务配置多个API Key进行访问

AICP 2.1.0

1.满血版Deepseek 671B大模型优化

①支持671B满血版满精度的分布式推理:支持671B大模型服务在多节点环境下进行并行推理,提升模型吞吐与处理能力

②支持低成本部署671B满血版大模型(混合精度):在 4 卡、8 卡场景下支持 671B 级别大模型的高效推理,满足 8 并发 80 tokens/s 性能目标

2.自定义服务

支持自定义镜像增删改查、自定义服务增删改查、自定义服务管理。可通过自定义服务支持大小模型混部场景,可通过vgpu+自定义镜像+自定义模型+自定义服务完成小模型的部署

3.vGPU

深信服通过软件方案实现CUDA请求劫持,无需英伟达切分授权,即可实现GPU切分和细粒度调度,大幅降低用户建设成本。支持创建训练、量化、模型服务、自定义服务时选择vGPU。算力最小粒度为1%,显存最小粒度是256MB

4.显卡异构与模型兼容

详情请见兼容性列表

5.支持外置存储

支持标准NFS协议第三方存储对接作为平台存储使用

AICP 2.0.0

1.数据集管理

支持admin在创建/编辑设数据集的操作时设置数据集权限

2.模型仓库

admin账号下支持创建和编辑模型时设置模型权限(默认:私有,支持选择私有、公有)

3.平台管理

1>支持添加/编辑算力池时将算力池共享给租户使用

2>支持创建/编辑网关时将网关给特定租户使用

4.安全saas&APEX适配

1>适配安全大模型

a、检测大模型

b、研判大模型

c、安全基座大模型

d、安全GPT大模型

e、数据安全大模型

2>安全小模式适配列表

a、运营GPT-辅助驾驶

secGptModelRerank

secGptModelEmbedding

b、运营GPT-自动驾驶

investigation

investigationRelation

AICP 1.1.0

模型训练管理

- 训练任务支持配置训练框架高级参数:在创建训练任务时,选择模型和算力规格后,系统会联动生成推荐的训练框架高级参数。用户可展开高级配置项对其进行修改。查看训练任务时能看到当前任务的训练框架参数配置,重新训练和断点训练也支持配置这些高级参数,为训练过程提供更多灵活性。

模型服务管理

- 推理任务支持配置 vllm 相关的高级参数:创建推理服务,选好对应模型和算力池后,会自动联动生成推荐的推理服务启动超参数。服务运行中不支持修改超参数,但查看服务详情可查看配置。在停止状态下编辑,能对推理超参数进行修改,方便用户根据需求调整。

模型加密

- 模型加密密钥优化:AICP 历史版本加密的模型导入 AICP1.1.0 版本,可正常启动推理服务并解密推理;AICP1.1.0 版本加密的模型在本版本推理也正常。不过,将其导入其他 AICP1.1.0 版本平台部署推理服务,无法正常解密,保障了模型加密的特定环境适配性。

平台关联

- 支持导入不同的配置 tar 包,适配兼容不同模型和硬件:平台支持导入更新版本的配置 tar 包以适配不同模型和硬件,包大小需在 20M 以内。导入时若与当前版本默认 tar 包不同,升级会覆盖并给出提示,用户需重新生成定制化 tar 包再导入。

- 支持查看当前版本兼容模型和硬件的情况,以及当前模型在平台上的能力支持范围:用户可查看当前版本模型与硬件的兼容列表,了解兼容适配的硬件和所有模型,还能知晓当前模型在平台上的能力支持范围,为模型使用提供参考。

安全 saas 适配

- 安全 saas - 分支配置 tar 包:模型相关配置支持导入安全相关的模型,修改推理服务相关配置时,能创建安全相关的模型推理服务,增强了平台在安全模型方面的应用能力。

- 运营大模型支持:支持运营检测大模型如 Qwen1.5 - 32B(AWQ INT4 量化)、Qwen2.5 - 32B(AWQ INT4 量化)的导入和推理,通过启动推理服务对外提供接口,满足运营检测场景需求。

- 研判大模型:支持研判 Mistral - 7B 大模型上传,可通过推理服务创建 GPT2 的模型服务,并对外提供多个接口,方便进行研判相关操作。

- 检测大模型:支持检测大模型 GPT2 + Triton 上传,能通过推理服务创建 GPT2 的模型服务,对外提供特定的推理接口,助力检测工作开展。

数据面重构

- 推理数据面镜像:升级 vllm 框架并重构推理数据面代码,更新了英伟达显卡的推理镜像,支持 vllm0.6.3 版本(仅限 N 卡),通过解耦数据面 web 框架,提高了性能和后续适配性。

- 压缩数据面镜像:重构压缩数据面代码,更新了 N 卡的压缩镜像,优化了数据压缩处理能力。

- 加密数据面镜像:重构加密数据面代码,更新了加密镜像,增强了数据加密方面的功能。

- 训练数据面镜像:重构训练数据面代码,更新了 N 卡的训练镜像,为训练过程提供更好的数据面支持。